Conteúdo desta página

Para que serve o arquivo robots.txt?

Um arquivo robots.txt informa aos mecanismo de busca quais URLs os robôs podem acessar em seu site. Isso é usado principalmente para aumentar a segurança proibindo ou permitindo o acesso de mecanismos específicos (ou todos) a determinadas partes do site.

Como criar um arquivo robots.txt

É bem fácil criar seu arquivo robots, mas é importante saber o que você quer dizer. Dizer que "todo site deve ser rastreado por qualquer buscador" não é diretriz e raramente verdade.

Veja abaixo um exemplo bem sucinto, mas completo do arquivo robots.txt:

Simples não é? E pode ser o suficiente, vamos entender essas linhas e ver outros exemplos de robots.txt mais para frente.

Este artigo do Google sobre robots.txt introduz o assunto e ensina o passo a passo para criar o seu.

User-agent em robots.txt

Essa linha específica para qual mecanismo de busca você está dando determinada diretriz. Os mecanismos são representados por agentes usuários, que são os robôs que fazem requisições ao acessar seu site e rastreá-lo. No primeiro exemplo, nós utilizamos "*" para representar "todos" agentes. Ou seja, estamos dizendo que todos agentes estão proibidos de acessar o diretório /cgi-bin/.

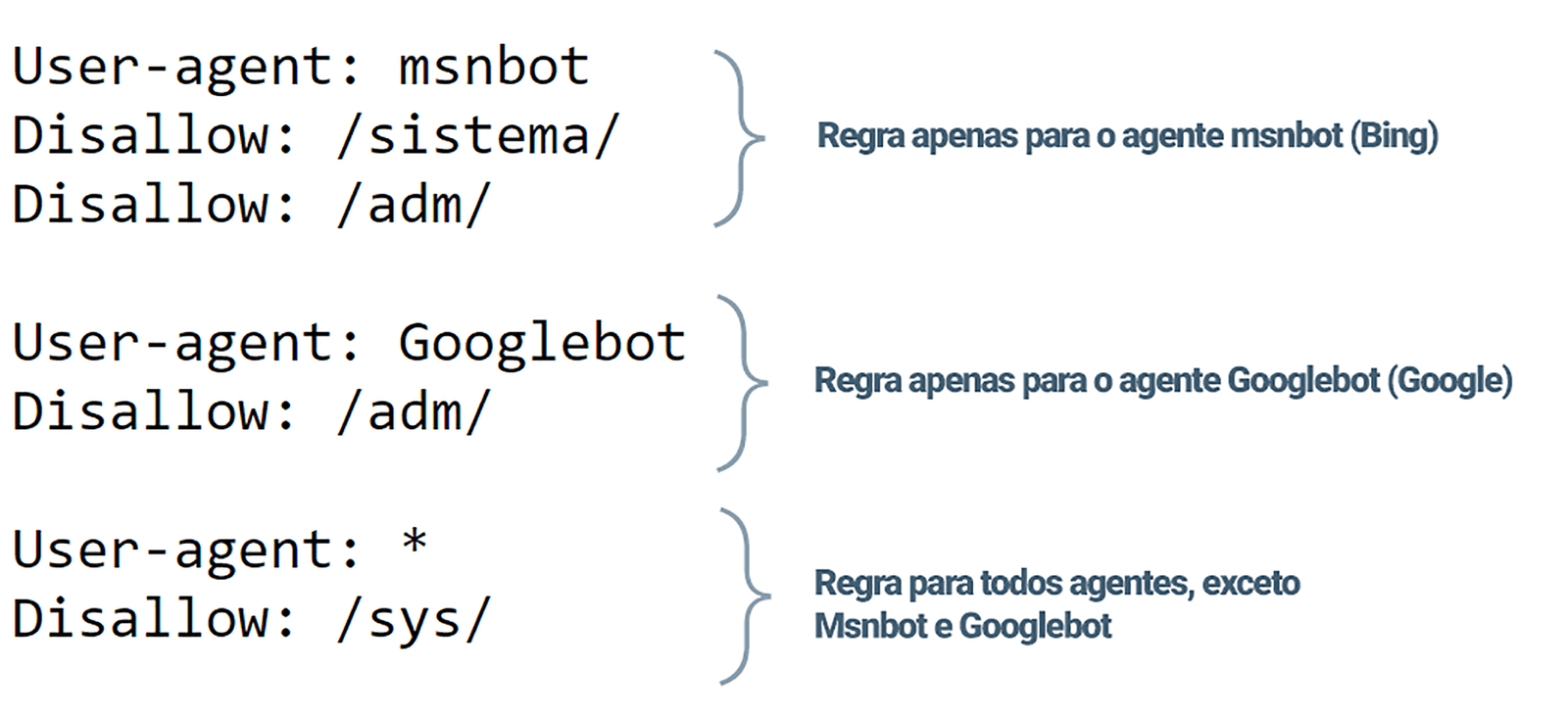

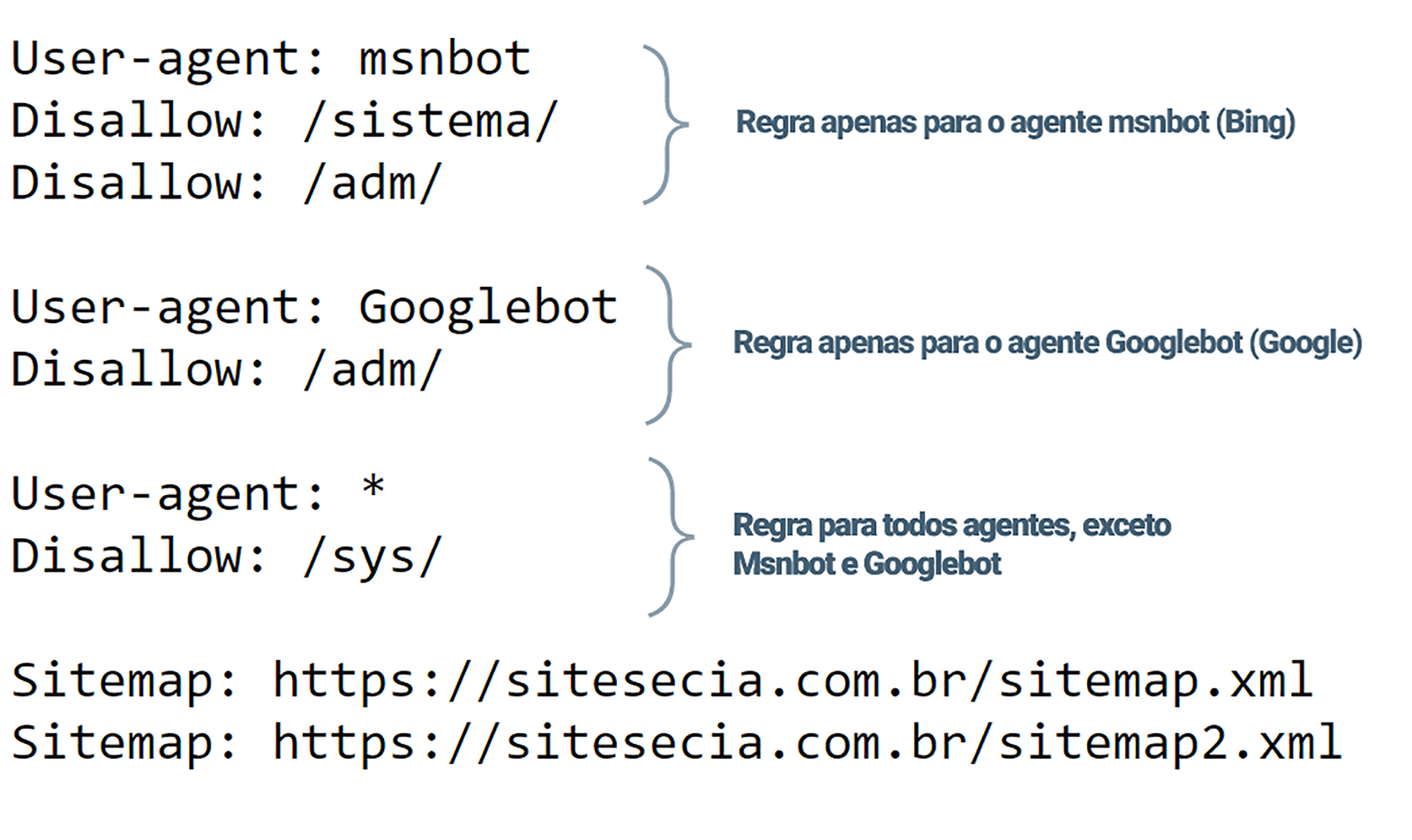

Em um arquivo robots.txt com várias diretivas de agente de usuário, cada regra de proibição ou permissão aplica-se apenas ao(s) agente(s) de usuário especificado(s) naquele conjunto particular separado por quebra de linha. Se o arquivo contiver uma regra que se aplica a mais de um agente de usuário, um rastreador só prestará atenção (e seguirá as diretivas em) o grupo de instruções mais específico. Vamos verificar um exemplo mais complexo:

Neste exemplo, estamos especificando que o agente msnbot (Bing) não pode acessar os diretórios /sistema/ e /adm/. Já o agente Googlebot (Google) não pode acessar apenas o conteúdo dentro de /adm/. Todos os outros agentes podem acessar estes diretórios, mas não podem acessar o diretório /sys/

Comandos allow e disallow em robots.txt

Você já percebeu que cada regra é agrupada por agente (ou bot, ou robô). Nesses grupos você pode especificar o que não deve ser acessado (Disallow) e o que deve ser acessado (Allow).

A princípio, tudo é permitido. Portando o comando allow só faz sentido para especificar alguma exceção do comando disallow. Por exemplo:

Disallow /sistema/ Allow /sistema/teste

Sitemap em robots.txt

Aqui fica mais interessante! Já falamos sobre sitemaps aqui e como eles podem ser importantes para seu site ser corretamente indexado.

Basta acrescentar uma nova linha para cada sitemap do seu siite, por exemplo:

Sitemap: https://sitesecia.com.br/sitemap.xml Sitemap: https://sitesecia.com.br/sitemap_produtos.xml

Nota: O comando sitemap é aceito apenas pelo Google, Ask, Bing, and Yahoo.

Veja agora um exemplo juntando todos os comandos que citamos aqui:

Práticas recomendadas de SEO

- Certifique-se de não bloquear nenhum conteúdo ou seção do seu site que deseja rastrear.

- Links em páginas bloqueadas por robots.txt não serão seguidos. Isso significa 1.) A menos que também estejam vinculados a outras páginas acessíveis por mecanismo de pesquisa (ou seja, páginas não bloqueadas por meio de robots.txt, meta-robôs ou outros), os recursos vinculados não serão rastreados e podem não ser indexados. 2.) Nenhum link equity pode ser passado da página bloqueada para o destino do link. Se você tiver páginas para as quais deseja que o patrimônio seja passado, use um mecanismo de bloqueio diferente do robots.txt.

- Não use apenas o robots.txt para evitar que dados confidenciais (como informações privadas do usuário) apareçam nos resultados. Para isto é mais garantido utilizar um método diferente, como proteção por senha ou a meta diretiva noindex.

- Alguns mecanismos de pesquisa têm vários agentes de usuário. Por exemplo, o Google usa o Googlebot para pesquisa orgânica e o Googlebot-Image para pesquisa de imagens.